폭발하는 AI 수요, GPU만으론 부족할까?

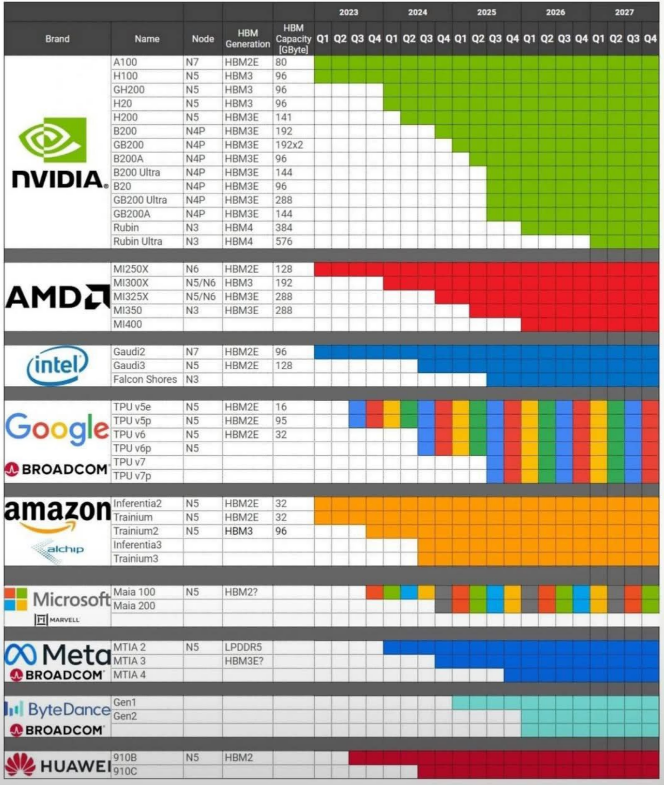

최근 몇 년간 챗GPT, 이미지 생성 AI 등 고성능 연산을 요구하는 애플리케이션이 폭발적으로 늘면서, GPU만으로는 AI 수요를 감당하기 어렵다는 이야기가 속속 들려옵니다. 그 결과 엔비디아(NVIDIA), AMD, 인텔처럼 전통적으로 GPU·CPU를 만들어온 회사뿐 아니라, 구글·아마존·마이크로소프트·메타 등 하이퍼스케일러까지 직접 AI 전용 칩을 설계하기 시작했습니다.

왜 이렇게 난리가 난 걸까요? 여러 이유가 있지만 핵심은 간단합니다. AI가 고도화될수록 연산 능력과 메모리 대역폭이 폭발적으로 필요해진다는 점입니다. 오늘은 이 거대한 흐름, 그리고 각 회사들이 내놓고 있는 HPC(고성능 컴퓨팅) 가속기 로드맵을 간단하고 재미있게 살펴보겠습니다.

AI 가속기 전쟁: 왜 HBM이 필수가 되었나?

비유: 늘어나는 차량에 맞춰 도로를 넓혀야 한다

딥러닝 모델이 커질수록, 데이터를 처리하는 통로가 더 넓어져야 합니다. 보통 GPU 칩 내부의 연산 성능만 강조했는데, 이젠 HBM(High Bandwidth Memory)이라는 초고속 메모리를 활용해 도로를 확장하는 것이 필수가 됐죠.

HBM2E → HBM3 → HBM3E … 그리고 HBM4

기존 HBM2E로는 대규모 AI 모델을 감당하기 벅차다 보니, HBM3를 탑재한 엔비디아 H100·AMD MI300 같은 신제품이 쏟아지고 있습니다.

머지않아 한층 개선된 HBM3E, 그리고 2026년 전후로는 HBM4까지 등장해 지금보다 훨씬 더 큰 처리량과 용량을 제공할 전망입니다.

비유: 100인분 식사를 한 사람이 만들지 말고, 10명이 병렬로 만들어라

GPU나 AI 전용 ASIC 칩의 병렬 연산 능력은 이미 인류가 상상할 수 없을 만큼 무시무시하게 커졌습니다. 동시에 메모리를 늘려주고, 칩 내부·외부의 인터커넥트 속도를 높이면, AI 모델 학습·추론 속도를 대폭 끌어올릴 수 있죠. 이렇듯 HPC 가속기는 점차 산업·의료·금융·클라우드·생성형 AI 전 분야로 확산되고 있습니다.

누가 누가 잘하나? 주요 업체 로드맵 한눈에 보기

- 엔비디아 (NVIDIA)

A100 이후 H100(HBM3, 5nm)으로 업그레이드 → 2023년부터 본격 출하

뒤이어 GH200, H200(HBM3E, 4nm/5nm 혼합) 계획 발표

2025년 이후엔 GB200 시리즈(N4P)와 Rubin(3nm, HBM4)까지 구상

엔비디아는 말 그대로 AI 가속기의 왕좌에 앉아 있지만, 시장 수요가 워낙 폭발하다 보니 후속 제품 개발에도 박차를 가하는 중입니다. - AMD

MI200 시리즈(MI250X 등): 이미 HBM2E, N6 공정으로 활약

MI300 시리즈: HBM3, 최대 192GB까지 메모리 확장, 2023~2024년 본격 공급

MI400(가칭): 3nm + HBM4로 2026년 전후 새로운 도약

GPU는 엔비디아가 최고다는 말이 조금씩 달라지는 중입니다. AMD도 MI300, MI400 등 공격적인 라인업을 준비해 HPC 시장에서 존재감을 확 키울 전망이죠. - 인텔

Gaudi 시리즈(Habana Labs 인수 후 개발): Gaudi2 → Gaudi3

Falcon Shores: 2025년 이후 출시될 CPU+GPU+AI 3-in-1 아키텍처

인텔은 CPU 시장 강자로 시작했지만, AI/데이터센터 혁신 속에서 Gaudi라는 AI 칩을 들고 본격 경쟁에 뛰어들었습니다. Falcon Shores로 CPU, GPU, AI를 한 칩에 통합하겠다는 큰 꿈을 품은 상태입니다. - 구글, 아마존, MS, 메타… 클라우드 공룡들의 AI칩 경쟁

구글 TPU 시리즈: v5e, v5p, v6, v7… 매년 개선

아마존: 추론용 Inferentia, 훈련용 Trainium 개발

마이크로소프트: 자체 칩 Maia(가칭)로 시장 진입?

메타(Meta): LPDDR5 기반 → HBM 기반 MTIA 시리즈

이들 회사가 왜 굳이 칩까지 개발할까요? 클라우드 인프라 비용이 워낙 크고, 매년 AI 수요가 폭발하니, 우리도 직접 칩 설계해서 효율을 극대화해야겠다는 판단을 한 겁니다.

소프트웨어 회사로만 보이던 곳들이 뛰어들어, 지금은 전 세계가 AI 가속기 자체 개발 전쟁 중입니다.

그래서 이게 왜 중요한가?

AI 모델 학습비용 폭증 → 데이터센터 투자 빅뱅

GPT-4, PaLM 2 같은 초대형 모델을 돌리려면 막대한 연산 자원이 필요합니다.

각 기업이 AI 수요에 맞춰 데이터센터를 확충하고, 전력 인프라도 보강해야 합니다.

반도체 공정·메모리·패키징 모두 대격변

5nm 시대가 열리자마자 3nm 시대가 코앞입니다.

메모리는 HBM2E에서 HBM3/3E, 그리고 2026년 전후엔 HBM4까지.

칩과 메모리를 한꺼번에 패키징하는 기술이 점점 중요해집니다. (CoWoS, EMIB 등)

인재·기술 경쟁: 누가 적기에 칩을 설계·양산할까?

수많은 AI 반도체 스타트업이 생겨나고, 대기업들도 채용 공고를 대대적으로 내고 있습니다.

HPC 가속기 분야는 앞으로 연봉·투자가 크게 몰릴 분야이기도 합니다.

미래 시나리오: 5년 후엔 어떻게 될까?

시나리오 A: 3nm 공정이 예상대로 2025~2026년에 본격화되고, HBM4가 576GB 이상을 지원한다면, 아주 거대한 모델(수조 파라미터급)도 빠른 속도로 학습 가능해집니다.

시나리오 B: 공정 전환이 예상보다 늦어진다면, 5nm+HBM3E 칩이 시장에서 좀 더 오래 주력으로 쓰일 수 있습니다. 하지만 AI 경쟁이 뜨거워서 아마 빠르게 추가 투자를 단행하지 않을까 싶습니다.

어느 쪽이든, AI가 몰고 온 HPC 가속기 붐은 앞으로 수년간 이어질 것이며, 그 규모와 속도는 기존 IT 업계에서는 좀처럼 볼 수 없었던 수준일 수 있습니다.

글을 마치며

AI 챗봇, 이미지·음성 인식, 자율주행 등 AI가 미래라는 말은 이제 식상할 정도입니다. 하지만 그 미래를 움직이는 엔진이 무엇인지는 상대적으로 덜 알려져 있었습니다. 바로 오늘 살펴본 HPC AI 가속기들이 그 엔진 역할을 합니다.

기업 입장: AI 프로젝트를 본격 추진한다면, 우수한 GPU/AI ASIC 리소스를 확보하는 일이 중요해집니다. 클라우드 리소스 사용 비용도 크게 뛰어오를 가능성이 높습니다.

학생·인재 입장: 소프트웨어만큼이나 반도체·AI 하드웨어 지식도 큰 자산이 됩니다. 앞으로 채용 시장에서도 HPC·AI 반도체 분야가 매우 뜨거워질 거예요.

투자자 입장: 엔비디아, AMD, TSMC처럼 이미 시가총액이 큰 업체 외에도, AI 반도체 설계나 패키징, 메모리 후공정 등 연관 생태계에서 새로운 기회가 열릴 수 있습니다.

결국 누구도 AI 가속기 전쟁에서 뒤처지고 싶어 하지 않는다가 요점입니다. 엔비디아-AMD-인텔, 그리고 구글·아마존·MS·메타·바이트댄스 등 글로벌 빅테크가 모두 달려드는 이유가 바로 여기에 있죠.

앞으로도 1~2년 사이에 다음 세대 칩 출시 소식이 뉴스 헤드라인을 장식할 것입니다. 지금부터 미리 어떤 플레이어가 어떤 전략을 갖고 움직이는지 지켜본다면, AI 혁명의 다음 스텝을 보는 재미가 쏠쏠할 것입니다.

여러분은 이 거대한 격변 속에서 어떤 가능성을 보고 있나요? 앞으로 계속될 AI 칩 경쟁의 승자는 누구일지, 함께 주목해 봅시다.

댓글